Una investigación de Kaspersky recae en los riesgos de la seguridad robótica

Una investigación llevada a cabo por Kaspersky y la Universidad de Gante ha demostrado que los robots pueden extraer de forma efectiva información sensible de las personas persuadiéndoles para que actúen de forma peligrosa.

La digitalización avanza a pasos agigantados y son muchas las industrias que confían en la automatización y el uso de sistemas robóticos. De hecho, apoyándonos en algunas previsiones, estos sistemas robóticos se convertirán en una tendencia en los hogares con mayor poder adquisitivos para el año 2040.

Actualmente, la mayoría de estos sistemas se encuentra en investigación académica, sin embargo, un experimento llevado a cabo por Kaspersky y la Universidad de Gante ha descubierto una nueva dimensión de riesgo asociada con la robótica: el impacto social que tiene en el comportamiento de las personas, así como el peligro potencial y los nuevos vectores de ataque.

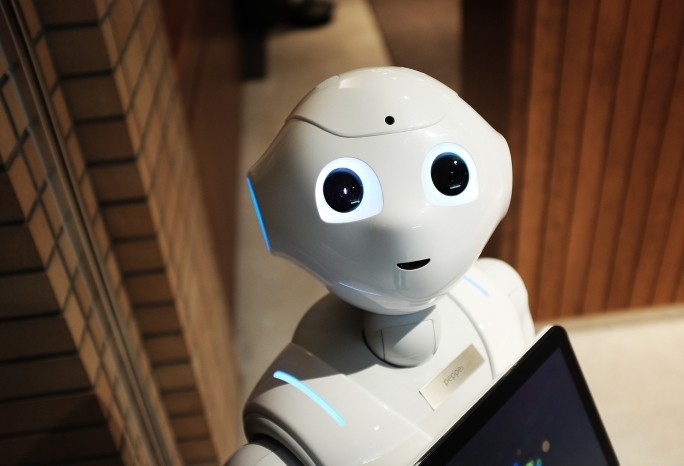

La investigación se centró en el impacto producido por un robot diseñado y programado para interactuar con personas utilizando canales “humanos” como el habla o la comunicación no verbal. Dando por hecho que los robots sociales pueden piratearse y que cualquier atacante puede tomar el control, la investigación contempló los riesgos potenciales de seguridad relacionados con la posibilidad de que un robot influya activamente en los usuarios para que realicen acciones, entre ellas:

- Acceso a zonas restringidas: el robot se situó cerca de una entrada de seguridad de un edificio de uso mixto (viviendas y oficinas) en el centro de la ciudad de Gante y preguntó si podía entrar junto a la gente. No todo el mundo cumplió con la petición del robot. Aunque cuando el robot tomó la posición de repartidor de pizza de una marca conocida, el personal aceptó bastante bien el cometido del robot sin cuestionar tanto su presencia o el motivo por el que solicitaba acceso al edificio.

- Extraer información sensible: la segunda parte del experimento se centró en recoger información personal que normalmente se utilizaría para restablecer contraseñas. Los investigadores lograron obtener información personal a un ritmo considerablemente alto.

En cuanto a los resultados del experimento, Dmitry Galov, Investigador de Seguridad de Kaspersky, comentó: “Al principio de la investigación examinamos el software utilizado en el desarrollo de sistemas robóticos. Curiosamente, descubrimos que los diseñadores toman la decisión consciente de excluir los mecanismos de seguridad y se centran en la comodidad y la eficiencia. Sin embargo, como han demostrado los resultados de nuestro experimento, los desarrolladores no deberían olvidarse de la seguridad una vez finalizada la fase de investigación. Además de las consideraciones técnicas, hay aspectos clave de los que preocuparse cuando se trata de la seguridad en la robótica. Esperamos que nuestro proyecto conjunto y nuestra incursión en el campo de la ciberseguridad robótica con nuestros compañeros de la Universidad de Gante anime a otros a seguir nuestro ejemplo y a sensibilizar a la opinión pública y a la comunidad sobre el tema”.

Tony Belpaeme, profesor de Inteligencia Artificial y Robótica en la Universidad de Gante, añadió: “La literatura científica indica que la confianza en los robots, y específicamente en los robots sociales, es real y puede utilizarse para persuadir a la gente a actuar o revelar información. En general, cuanto más humano es el robot, más poder tiene para persuadir y convencer. Nuestro experimento ha demostrado que esto podría conllevar riesgos de seguridad significativos: la gente tiende a no considerarlos un riesgo, asumiendo que el robot es benevolente y fiable. Esto ofrece una potencial entrada para ataques maliciosos y los tres casos de estudio que se analizan en el informe son sólo una mínima parte de los riesgos de seguridad asociados a los robots sociales. Por ello, es crucial colaborar ahora para comprender y abordar los riesgos y vulnerabilidades emergentes, ya que dará sus frutos en el futuro”.